L'articolo che segue è stato già pubblicato nel febbraio 2019. Questa è la revisione di gennaio 2024 (N.d.D.)

Abstract

“Cos’è un campo elettromagnetico? Qual’è l’effetto del campo elettromagnetico emesso da un dispositivo mobile o da un’antenna sul corpo umano? Qual’è il livello di pericolosità attualmente stabilito dallo IARC (International Agency for Research on Cancer)? Quali sono i parametri da considerare prima dell’acquisto di un dispositivo mobile? Quali contromisure possiamo adottare per limitare i rischi nell’uso quotidiano dei nostri device?”

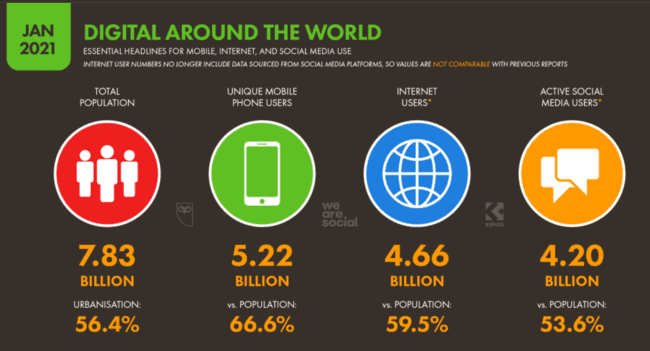

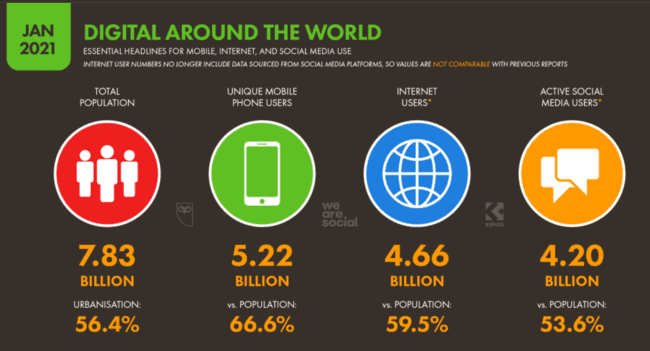

La connessione alla rete Internet nel mondo è in continua crescita. In particolare assistiamo all’uso sempre più intensivo di dispositivi mobili. Ad esempio le indagini statistiche condotte da “We Are Social” assieme a “Hootsuite” [1] a livello mondiale hanno raccolto, tra gli altri, i dati riportati in figura.

Come si può notare gli utenti che fanno uso di un dispositivo mobile per il collegamento sono più di 5 miliardi in tutto il mondo. Sempre secondo questa indagine la crescita mondiale relativa all’uso dei dispositivi mobili è del 4%, pari a più di 200 milioni di dispositivi all’anno. In particolare in Italia, a Gennaio 2018, circa 49 milioni di utenti usano un dispositivo mobile per collegarsi ad Internet, ovvero circa l’83% della popolazione attiva.

Ecco la situazione nel 2018 (quando era stato scritto questo articolo).

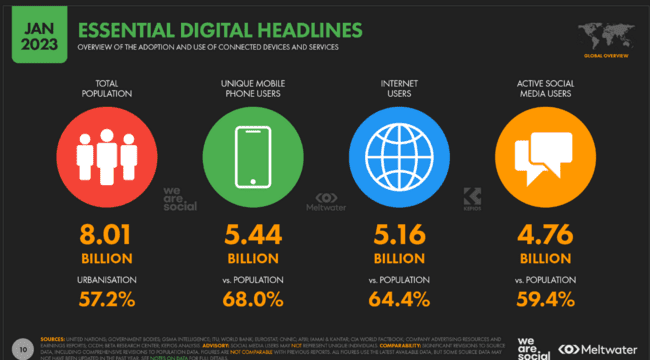

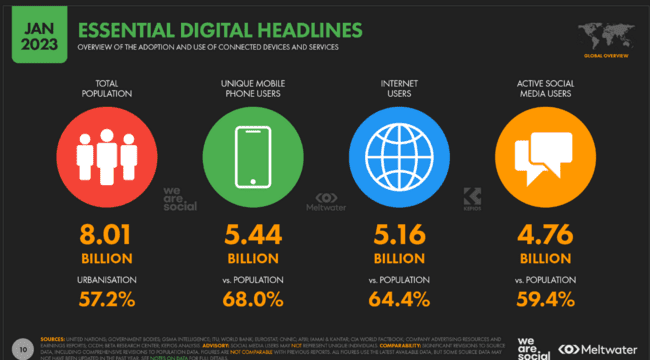

Qui riportiamo un aggiornamento al 2023

Questi sono i link per i report mondiali

https://datareportal.com/reports/digital-2021-global-overview-report

https://datareportal.com/reports/digital-2023-global-overview-report

Questo è il link per i report italiani

https://wearesocial.com/it/blog/2021/02/digital-2021-i-dati-italiani/

Com’è noto il collegamento di un dispositivo mobile, ovvero uno smartphone o altro device facente uso di una scheda telefonica o tecnologia Wi-Fi, alla rete Internet, si basa sui campi elettromagnetici. Questo è vero anche per le normali telefonate, anzi a maggior ragione in quanto, di solito, usiamo il telefonino poggiandolo in prossimità dell’orecchio.

Pertanto si impone una riflessione sulla eventuale pericolosità dei campi elettromagnetici nella telefonia mobile.

La questione andrebbe affrontata sotto due diversi punti di vista:

- esposizione ai campi e.m. dovuti alle antenne disposte nei diversi punti degli insediamenti urbani

- esposizione al campo e.m. del dispositivo mobile che stiamo usando

Gli effetti e le relative analisi sono infatti diversi nei due casi. Nel caso delle antenne il nostro corpo, normalmente, è esposto interamente alla radiazione ma a distanze ragguardevoli. Nel caso degli smartphone invece si è a diretto contatto con il dispositivo.

Procediamo quindi con ordine cercando di comprendere, senza troppi tecnicismi:

- cosa è un campo elettromagnetico e come sia possibile che questo realizzi un collegamento a distanza

- quali sono i parametri utilizzati per l’analisi del rischio dovuto all’esposizione dei campi e.m. (che i costruttori di telefonini devono obbligatoriamente riportare)

- quali sono i risultati degli studi fino ad ora condotti sugli effetti dei campi e.m. sul corpo umano

- quali accorgimenti possiamo eventualmente prendere per limitare gli effetti dei campi e.m.

Cos’è un campo elettromagnetico

Si tratta di due onde, una dovuta al campo elettrico e l’altra al campo magnetico, che, se la frequenza di emissione è sufficientemente elevata, hanno la straordinaria proprietà di viaggiare contemporaneamente nello spazio. L’altra caratteristica fondamentale è che tale campo può contenere informazioni, le quali vengono immesse attraverso una tecnica detta modulazione e rilevate attraverso l’azione opposta di demodulazione. Quindi di fatto un campo elettromagnetico trasmette informazioni.

E fin qui tutto molto bello. Il problema è che le onde radio, ovviamente, interagiscono con la materia circostante e, nel caso in cui la materia in questione sia il nostro corpo, sorge il legittimo dubbio che questo possa venire in qualche modo danneggiato.

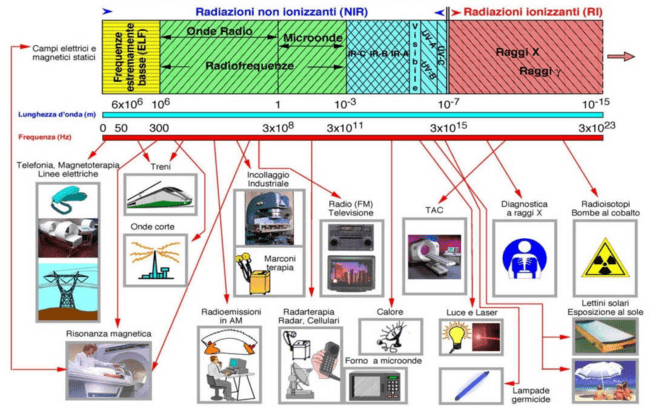

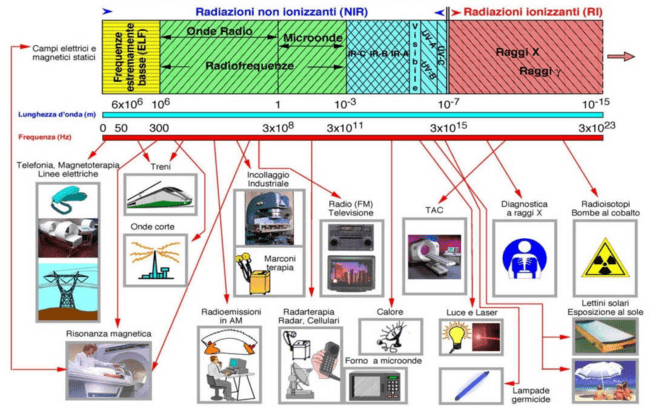

Diciamo subito che i campi elettromagnetici cui siamo esposti, non sono di sola origine artificiale come possiamo notare dal seguente schema [2].

Nella figura è anche evidenziata la tipica classificazione in base alla frequenza di emissione ovvero secondo la lunghezza d’onda della radiazione. Per coloro che fossero più avvezzi alla fisica o alla matematica ricordiamo la nota relazione

dove c=velocità della luce, f=frequenza, 入=lunghezza d’onda.

Osservando lo schema possiamo subito fare la seguente (in parte tranquillizzante) osservazione: le onde radio usate nella telefonia mobile sono NON ionizzanti, cioè non provocano una trasformazione delle cellule con cui vengono a contatto ma “solo” la loro oscillazione con conseguente riscaldamento dei tessuti. Questo in effetti è il principio di funzionamento di un forno a microonde: cuociamo i cibi alterandone poco le caratteristiche. Resta ovviamente da chiarire se questo effetto sia nocivo per l’uomo nel caso dell’uso dello smartphone. Studi recenti, inoltre, sembrano mettere in dubbio la natura non ionizzante.

Parametri per lo studio degli effetti dei campi e.m. sul corpo umano

Consideriamo prima il caso dell’esposizione al campo e.m. prodotto da un’antenna. SI usa in questo caso la cosidetta approssimazione di “campo lontano” secondo la quale il campo elettrico ed il campo magnetico sono assimilabili ad onde piane le cui intensità sono legate dalla relazione E/H = 377.

Normalmente viene misurato il solo campo elettrico [V/m] dato che gli effetti del campo magnetico si possono ricavare usando la formula precedente.

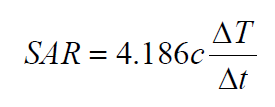

Per quanto riguarda l’uso dello smartphone, dato che non vale più l’approssimazione di campo lontano e la relazione tra campo elettrico e magnetico è più complessa della semplice proporzionalità, si usa invece una grandezza che dipende dalla rapidità con cui il tessuto investito dalla radiazione si scalda, il SAR (Specific Absorption Rate) [W/kg]:

=variazione di temperatura, =intervallo di tempo in cui avviene la variazione di temperatura, c=calore specifico del tessuto in esame.

A riguardo facciamo due osservazioni. La prima concerne il metodo di misura del SAR. Evidentemente sarebbe impossibile determinare tale grandezza applicando direttamente la definizione in quanto la misura risulterebbe dannosa per il tessuto in questione. Si usa in realtà un’altra definizione correlata direttamente con la potenza emessa dal dispositivo misurabile senza pericolo per il corpo umano.

La seconda è che, come già accennato, i costruttori devono comunicare il SAR del dispositivo mobile in modo che l’utente ne sia a conoscenza.

La Comunità Europea ha adottato una normativa armonizzata che fa proprio il limite SAR di 2,0 W/Kg (2W/kg per testa e corpo, 4 W/kg per gli arti). Il produttore, sotto la sua responsabilità, dichiara che il prodotto è conforme alla normativa comunitaria. Senza tale dichiarazione non è possibile ottenere la marcatura CE. Un dispositivo con marcatura CE garantisce il rispetto delle norme comunitarie in materia di emissioni elettromagnetiche.

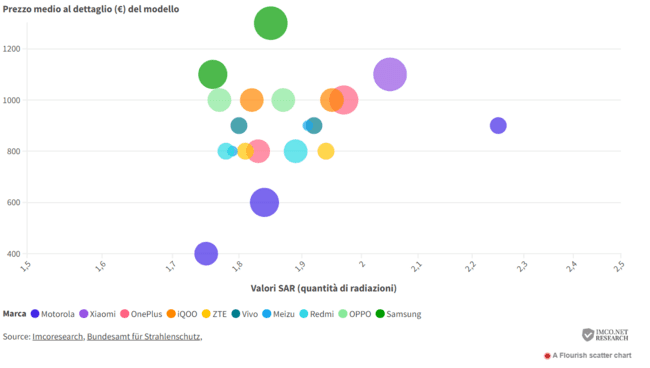

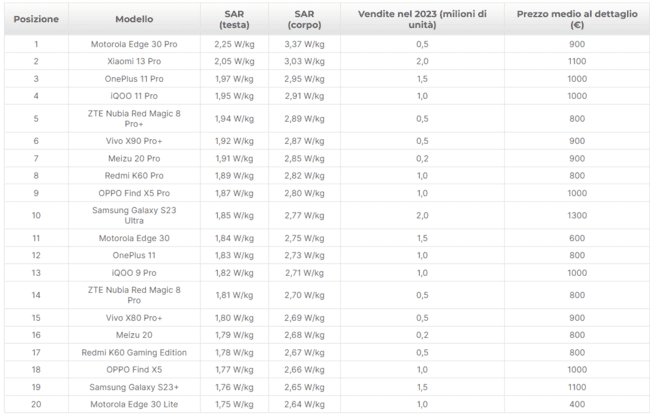

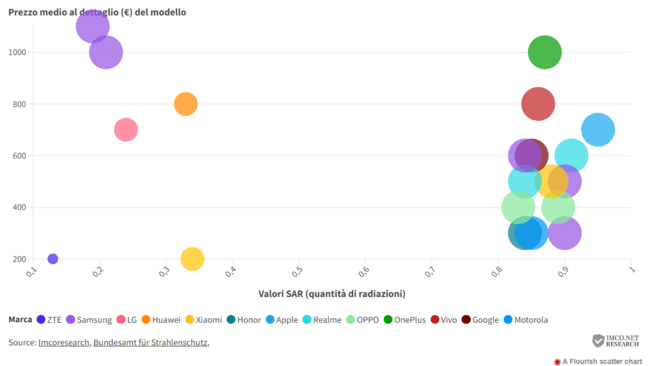

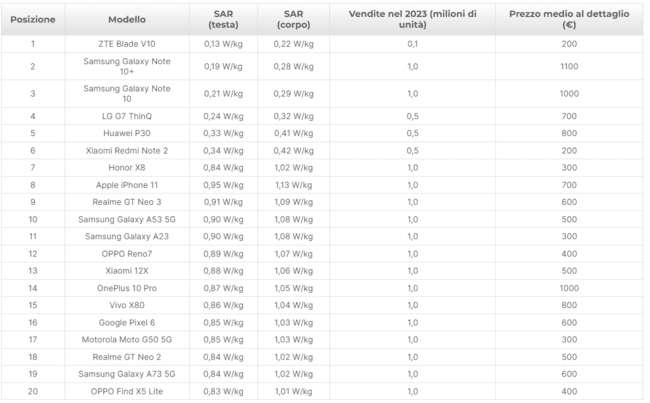

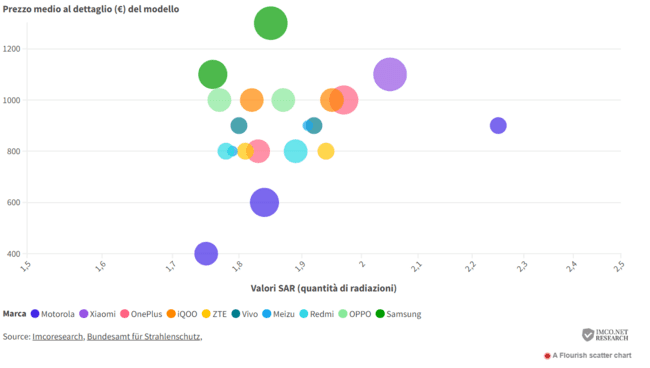

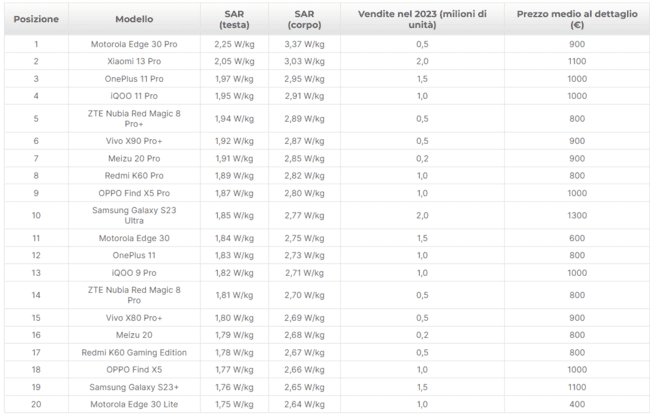

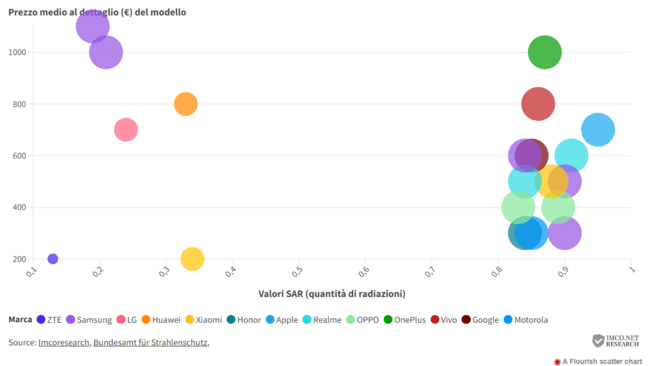

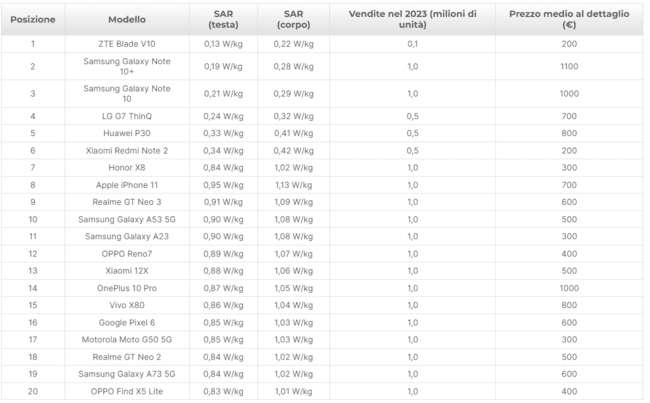

Di notevole interesse è la classificazione degli smartphone in base al SAR e la loro comparazione con il prezzo di vendita [8]. L'Ufficio federale tedesco per la protezione dalle radiazioni, Bundesamt für Strahlenschutz, ha effettuato una raccolta dettagliata di dati provenienti da una vasta gamma di telefoni, quantificato i livelli di radiazioni emessi e reso pubblici tali dati.

I 20 smartphone che emettono più radiazioni

Vediamo ora, sempre dalla stessa fonte

I 20 smartphone con valori SAR più bassi

E’ da tenere presente che i dati sulle vendite sono stime e possono variare a seconda della fonte. Il prezzo reale di un particolare modello può differire in base al rivenditore e al paese. Inoltre, è importante considerare che i prezzi dei modelli possono fluttuare nel corso del tempo.

In sintesi, sembra che i valori SAR non influiscano in modo significativo sulle vendite o sui prezzi degli smartphone. Probabilmente ciò è dovuto al fatto che tale parametro non viene tenuto in debita considerazione al momento dell’acquisto.

Risultati degli studi

Studi per evidenziare eventuali effetti non termici (cioè ionizzanti e quindi potenzialmente più pericolosi) del campo e.m. in zone poste in prossimità di antenne sono stati condotti fin dagli anni ottanta, inizialmente considerando impianti di tipo radiotelevisivo, poi anche per la telefonia mobile. Famoso in Italia lo studio sulle antenne di Radio Vaticana. Si discusse molto dei risultati di tale studio in quanto, sebbene evidenziassero “un eccesso di rischio di leucemia in prossimità della stazione radio e un decremento del rischio a distanza crescente dagli impianti”, come per altri studi analoghi, “i risultati delle analisi epidemiologiche non forniscono però evidenze conclusive circa una possibile associazione causale tra esposizione a RF e aumento del rischio di leucemie”. [3]

In particolare il campione statistico non era sufficientemente significativo per numero di casi esaminati e per le metodologie usate nell’analisi che non tenevano conto di diversi fattori significativi dal punto di vista statistico e tecnico.

Anche studi più recenti sulle celle radio base per telefonia mobile non hanno evidenziato con sufficiente determinazione la corrispondenza tra esposizione a campi e.m. (nei limiti consentiti dalla legge) ed insorgenza di patologie.[4]

Pertanto:

“Sulla base dei risultati della ricerca scientifica ad oggi disponibili (2011 ndr), l’Associazione Internazionale per la Ricerca sul Cancro dell’Organizzazione Mondiale della Sanità, ovvero IARC (International Association for Reasearch on Cancer), ha classificato i campi elettromagnetici a radiofrequenza quali “possibili cancerogeni” (classe IIB). Tale classificazione si riferisce, in particolare, a limitate evidenze di cancerogenicità dell’esposizione a telefoni mobili. Le evidenze si considerano limitate in quanto, anche se rendono credibile un’associazione causale tra esposizione e induzione di tumori, non permettono di escludere la presenza di fattori casuali che inficino l’attendibilità di tale associazione”. [2]

Si riporta qui, per completezza, la classificazione dello IARC:

- Group 1: Carcinogenic to humans.

- Group 2A: Probably carcinogenic to humans.

- Group 2B: Possibly carcinogenic to humans.

- Group 3: Not classifiable as to carcinogenicity in humans.

Studi più recenti tuttavia hanno innalzato la soglia di attenzione sull’importante problema relativo ai pericoli derivanti dall’esposizione al campo e.m. con particolare riferimento alla telefonia mobile. [5] Uno studio dell’Istituto Ramazzini di Bologna, che risale a Gennaio 2017 ha evidenziato la correlazione tra le onde radio emesse da ripetitori (campo lontano) per telefonia mobile, simulando l’esposizione per valori tipici stimati in Italia, e l’insorgenza di tumori anche entro i limiti finora ritenuti sicuri. Tale studio è stato condotto con valori molto più bassi rispetto ad un altro analogo condotto negli Stati Uniti (NTP, 2005) nel quale si volevano stabilire gli effetti dell’uso del cellulare per le conversazioni (campo vicino).

“Il nostro studio conferma e rafforza i risultati del National Toxicologic Program americano … sulla base dei risultati comuni, riteniamo che l’Agenzia Internazionale per la Ricerca sul Cancro (IARC) debba rivedere la classificazione delle radiofrequenze, finora ritenute possibili cancerogeni, per definirle probabili cancerogeni”.

Recentemente, quindi, gli esperti, sulla scorta degli studi precedenti e grazie ad un numero maggiore e più significativo di casi esaminati nonché al perfezionarsi delle tecniche sperimentali, ritengono più probabile una relazione tra patologie ed esposizione ai campi e.m. di ripetitori e dispositivi mobili.

Le contromisure

Poiché la pericolosità del campo e.m. è legata alla distanza dalla fonte di radiazione ed alla durata dell’esposizione il buon senso raccomanda di tenere il dispositivo mobile il più possibile distante dal corpo (usando ad esempio un auricolare durante la conversazione) e per tempi brevi. Inoltre è fortemente consigliabile evitare di tenere il cellulare, o altro dispositivo mobile, accesso in prossimità del corpo (in particolare la testa) durante le ore di riposo. Essendo inoltre dimostrato che la potenza erogata da uno smartphone è minore se c’è pieno campo, meglio evitare situazioni nelle quali la ricezione è scarsa. Si tenga anche presente che la potenza emessa diminuisce sensibilmente con la tecnologia usata dal nostro dispositivo (nei primi ETACS era notevolmente più elevata che negli attuali 4G).

Da evitare poi l’uso dello smartphone da parte di bambini in quanto più sensibili agli effetti del campo e.m. Infine è buona norma informarsi sul livello SAR dei propri dispositivi mobili consultando le caratteristiche sul sito del costruttore. Esistono numerosi articoli sempre aggiornati in proposito. (si veda ad esempio [6] [8]).

Per quanto riguarda i ripetitori c’è da dire che la normativa vigente prevede, per la loro collocazione e potenza, valori di campo molto inferiori a quelli ritenuti pericolosi.

Circa quest’ultimo punto e le modalità di uso dei vari dispositivi atte a limitare i rischi dovuti all’esposizione ai campi e.m.si veda la già citata relazione [2] e l’ottimo articolo [7] dove si danno utili indicazioni anche riguardo a dispositivi elettrici diversi dagli smartphone.

Conclusioni

Attualmente la pericolosità dei campi e.m. emessi dalle antenne è ancora classificata come possibile e non probabile, pertanto non sembra opportuno rinunciare alle potenzialità offerte dai nostri dispositivi mobili. Come accade in generale nella vita, non eccedere nell’utilizzo ed adottare le opportune precauzioni sembra essere, attualmente, il migliore compromesso tra uso della tecnologia e sicurezza.

*Ingegnere elettronico - Docente Esperto di telecomunicazioni

RIFERIMENTI BIBLIOGRAFICI

[1] We Are Social - Hootsuite (2018). Digital In 2018 Report https://wearesocial.com/it/blog/2018/01/global-digital-report-2018

[2] ARPA Piemonte - Dipartimento Radiazioni - Sara Adda, Laura Anglesio, Alberto Benedetto, Enrica Caputo, Mauro Mantovan, Massimiliano Polesel - coord. Giovanni D’Amore (2014). ESPOSIZIONE UMANA A RADIOFREQUENZE. STUDIO SULL’IMPATTO DELLA TELEFONIA CELLULARE E SULLE MODALITÀ DI UTILIZZO DEL TELEFONINO PER LA RIDUZIONE DEI RISCHI

[3] Michelozzi P et al (2002). Adult and Childhood Leukemia near a High-Power Radio Station in Rome, Italy. Am J Epidemiol

[4] Roosli M., Frei P., Mohler E. and Hug K. (2010) Sistematic Review on the health exposure to radiofrequency electromagnetic fields from mobile phone base stations. Bull. World Health Organ.

[5] Ruggiero Corciella - Corriere della sera (2017). Antenne radio per i cellulari: nei topi causano tumori delle cellule nervose

[https://www.corriere.it/salute/18_marzo_21/antenne-radio-cellulari-topi-causano-tumori-cellule-nervose-0a9547aa-2cf3-11e8-af9b-02aca5d1ad11.shtml?refresh_ce-cp]

[6] Lorenzo Delli (2018). 10 popolari smartphone con valore SAR basso e 10 con valore SAR più alto (aggiornato marzo 2018)

https://www.mobileworld.it/2018/03/12/smartphone-top-10-sar-basso-101681/

[7] Bruno Orsini (2014). Effetti dell’esposizione del corpo umano ai campi elettromagnetici

http://www.meccanismocomplesso.org/effetti-dellesposizione-del-corpo-umano-ai-campi-elettromagnetici/

[8] IMCO.NET RESEARCH. Classifica degli smartphone più pericolosi per la salute

https://www.imiglioricasinoonline.net/smartphone-che-emettono-piu-radiazioni/