Abstract - L’ azione congiunta dei Big data, del Cloud e I.A (apprendimento automatico) sta velocemente producendo un aumento esponenziale della superficie digitale con un incremento esponenziale di minacce cybernetiche: nuove vulnerabilità, nuovi schemi di attacco, nuovi attori di minaccia sono sempre più frequenti.

* Docente - Dott.ssa in Scienze Politiche

Spesso quando si parla di cybersecurity e Intelligenza artificiale si identificano come un’arma a doppio taglio perché se da una parte l’uno può essere l’alleato dell’altra rispondendo agli attacchi e rendendo più resiliente il perimetro informatico; dall'altra parte anche gli attori malevoli la possono utilizzare e creare i vari attacchi cibernetici. In questo articolo vediamo il loro rapporto come possono aiutarsi vicendevolmente la cybersecurity e l’intelligenza artificiale e quali sono i trend del momento, quali le opportunità quali i rischi.

Dualismo: cybersecurity e Intelligenza artificiale (IA)

Secondo il Security Summit di marzo del 2021 che presenta l’ultimo rapporto CLUSIT (Associazione Italiana per la Sicurezza Informatica) sottolinea come nel 2020 gli attacchi cyber nel mondo sono aumentati del 12% rispetto all’anno precedente con danni globali che valgono 2 volte il PIL italiano tra cui il 10% ha sfruttato il tema Covid-19.

Il 14% degli eventi è stato dovuto a spionaggio cyber: nel mirino anche lo sviluppo dei vaccini. L’utilizzo dei malware (42%), tra i quali spiccano i cosiddetti ransomware; di tecniche sconosciute” come i casi di data breach, (per il 20%), e poi la maggior parte degli attacchi è rappresentato da phishing & social engineering (15% del totale);

Secondo i vari report gli attacchi informatici sono aumentati per l’emergere di due condizioni: da una parte l'esplosione del consumer web ha direzionato le aziende ad offrire i propri prodotti e servizi basati sull'intelligenza artificiale, dall'altra parte vi è la complessità degli attacchi che si stanno facendo sempre più importanti e mirati.

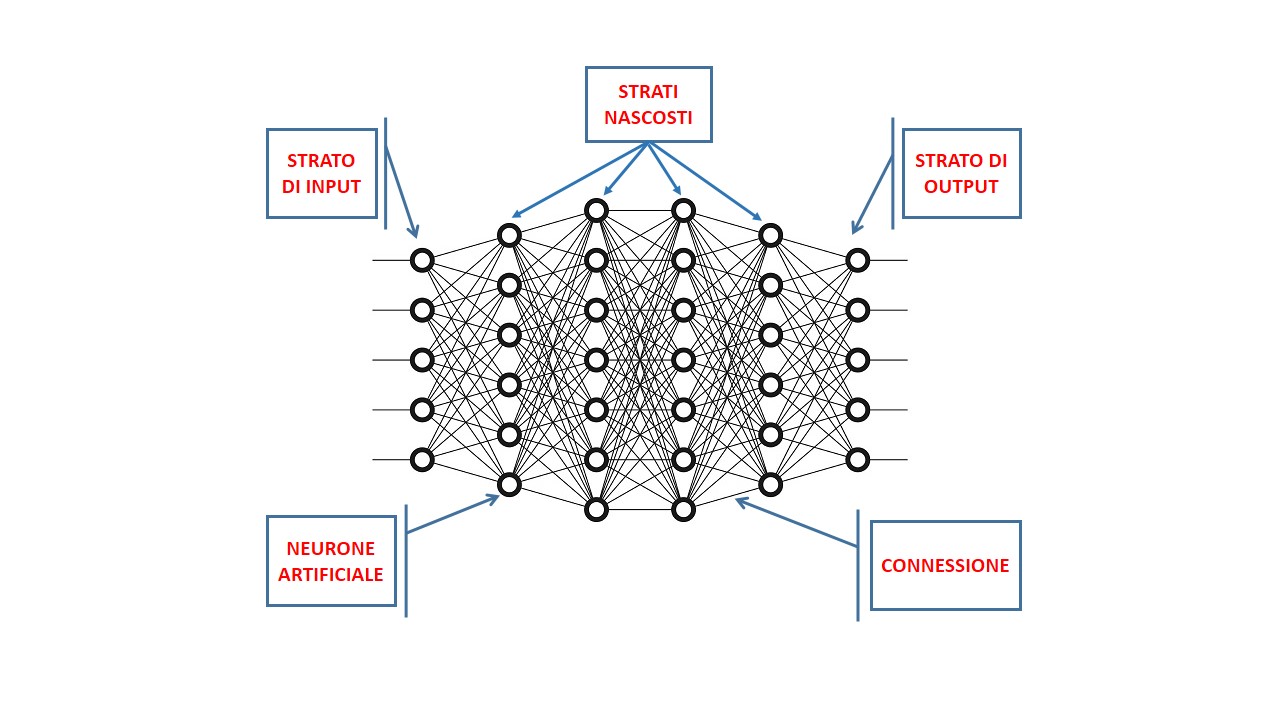

Il mercato dei prodotti di cybersecurity ha visto negli ultimi anni soluzioni di I.A. che includono il machine learning (apprendimento automatico), sia per analizzare nuovi malware (software malevoli) sia per trovare nuovi tipi di attacco alle reti.

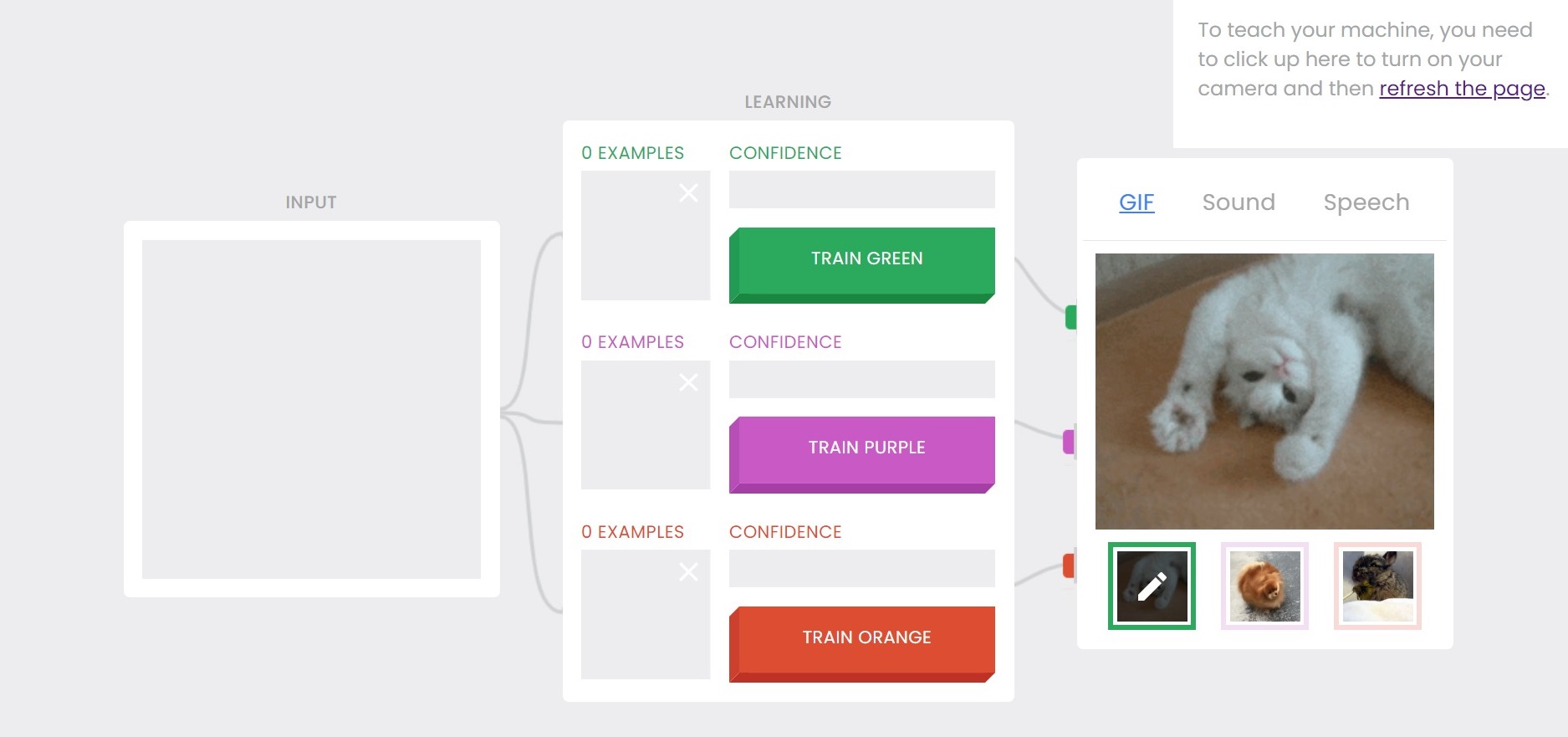

Ma cosa può fare l'intelligenza artificiale per la cybersecurity? Innanzitutto l’ I.A. ha diverse applicazioni nella cybersecurity, che si differenziano a seconda delle tecnologie utilizzate (ad esempio la machine learning, natural language processing cioè il processo di trattamento automatico mediante un calcolatore elettronico delle informazioni scritte o parlate in una lingua).

I campi di azione di essa sono fondamentalmente due: sono quelli di pattern recognition e anomaly detection. (ossia di riconoscimento di un modello e rilevamento di anomalie).

La pattern recognition consiste nell'analisi e identificazione di sotto-aree dell'apprendimento automatico all'interno di dati grezzi al fine di identificarne la classificazione, cercare di conoscere alcuni schemi; quali quelli di attacco o di difesa: ad esempio in una azienda l’I.A. cerca di riconoscere e indicizzare i vari attacchi informatici.

L’anomaly detection, ossia il rilevamento di anomalie è l'identificazione di oggetti, eventi o osservazioni rari che sollevano sospetti differendo in modo significativo dalla maggior parte dei dati.

In particolare, la tecnologia di riferimento è quella del machine learning, che aiuta nell'individuazione di modelli (pattern) di attacco - come nei firewall (componente hardware e/o software di difesa perimetrale di una rete) e negli intrusion detection system (un dispositivo software o hardware utilizzato per identificare accessi non autorizzati ai computer o alle reti locali) - o nel riconoscere il malware quando gli altri metodi si sono rivelati inefficaci o inconclusivi - generare alert (un servizio di rilevamento) e attivare contromisure automatiche.

Rispetto ai ransomware per esempio una I.A. può consentire rispetto ai contenuti sospetti la classificazione e di conseguenza o potranno essere cestinati o resi inaccessibile all'utente ordinario.

In che modo le aziende dovrebbero utilizzare l’intelligenza artificiale e migliorare le loro performance?

Rispetto agli attacchi informatici passati ci sono dinamiche diverse. Nel frattempo, le reti sono diventate sempre più complesse. Con un numero di connessioni interne ed esterne in continua crescita, è diventato sempre più difficile tenere traccia di tutte le attività della rete e impostare parametri e firme che siano in grado di fornire solo il livello base di protezione. I perimetri delle reti sono sostanzialmente diventati ridondanti, mentre le minacce informatiche evolvono in modi imprevedibili.

Non possiamo più fare affidamento ad una cybersecurity su un perimetro informatico fisico perché non esiste più quello definito dallo spazio aziendale dell'ufficio. Il concetto di rete aziendale in piena pandemia è cambiato: molti dipendenti delle aziende lavorano in smart working e il perimetro informatico comincia a diventare molto difficile da stabilire, non si è più dentro lo stesso ufficio, ma si è dislocati qua e là e decade il principio della sicurezza in profondità per mancanza di perimetro.

La Sicurezza Informatica sta diventando sempre più decentralizzata: non vi è più un data center (un'unità organizzativa), ma quelli che sono gli asset digitali (qualsiasi contenuto archiviato digitalmente) sono la maggior parte residenti in cloud. Dobbiamo, quindi, ripensare al concetto dell’infrastruttura digitale, su quali applicazione risiede: stiamo parlando di uno spazio digitale che possiamo portare alla vista di una intelligenza artificiale affinché essa possa apprendere al normale funzionamento del business e non di attacchi, non di una mera classificazione binaria, ma di qualcosa che va oltre e cerchi di andare oltre le sfumature; occorre capire il contesto.

L’ analista di cybersecurity dovrebbe essere in grado di operare su enormi quantità di dati con accuratezza e velocità e imparando da tutti i falsi positivi e falsi negativi che via via incontra in modo da poter raffinare l’accuratezza delle future analisi, ma gli esseri umani non possono essere così accurati e veloci ed ecco l’intervento dell’I.A.

Il cybercrime è passato in pochi anni da pochi target di alto profilo, a molti target di basso profilo distribuiti e diffusi e l’I.A. può proteggere i sistemi, identificare e prevenire gli attacchi sfruttando il potere dell'analisi di grandi quantità di dati.

In che modo i pirati informatici sfrutteranno l'intelligenza artificiale?

Ci sono stati i pacchetti di software rilasciati nelle reti con lo scopo di spiare e dare le informazioni a chi sta dietro per poter mascherare l'attività da parte dell'attaccante come se fossero delle attività legittime di un qualche funzionario, un utente di un’azienda.

Ci sono state tante email nelle campagne direzionate sul covid relative ai test e ai vaccini ed erano campagne in realtà del tutto fasulle anche con l'introduzione del nome dell'azienda; queste sono campagne di automazione piuttosto che di intelligenza artificiale vera e propria.

Altro esempio è il deepfake una tecnica utilizzata dall’I.A. per combinare e sovrapporre immagini e video esistenti con video o immagini originali, tramite una tecnica di apprendimento automatico.

I deepfake sono foto, video e audio creati grazie a software di intelligenza artificiale (AI) che, partendo da contenuti reali (immagini e audio), riescono a modificare o ricreare, in modo estremamente realistico, le caratteristiche e i movimenti di un volto o di un corpo e a imitare fedelmente una determinata voce.

La parola deepfake è un neologismo nato dalla fusione dei termini “fake” (falso) e “deep learning”, una particolare tecnologia AI. Le tecniche usate dai deepfake sono simili a quelle delle varie app con cui ci si può divertire a modificare la morfologia del volto, a invecchiarlo, a fargli cambiare sesso, ecc. (…)

La materia di partenza sono sempre i veri volti, i veri corpi e le vere voci delle persone, trasformati però in “falsi” digitali è una forma particolarmente grave di furto di identità. Le persone che compaiono in un deepfake a loro insaputa non solo subiscono una perdita di controllo sulla loro immagine, ma sono private anche del controllo sulle loro idee e sui loro pensieri, che possono essere travisati in base ai discorsi e ai comportamenti falsi che esprimono nei video. Le persone presenti nei deepfake potrebbero inoltre essere rappresentate in luoghi o contesti o con persone che non hanno mai frequentato o che non frequenterebbero mai, oppure in situazioni che potrebbero apparire compromettenti. In sostanza, quindi, un deepfake può ricostruire contesti e situazioni mai effettivamente avvenuti e, se ciò non è voluto dai diretti interessati, può rappresentare una grave minaccia per la riservatezza e la dignità delle persone. (Vademecum Garante per la protezione dei dati).

Questo porta a forme specifiche di azioni psicologicamente e socialmente molto dannose, ad esempio il “revenge porn”, cioè la condivisione online - a scopo di ricatto, denigrazione o vendetta, da parte di ex partner, amanti o spasimanti respinti, etc., oppure altre forme di illeciti quali il sexting, pornografia illegale e pedopornografia.

Tutto questo è possibile perché i software open source sono molto accessibili; per crearli è semplice e i software o app deepfake in circolazione sono abbastanza accurati e particolarmente prestanti.

Conclusioni

Diversi sono i limiti dell’I.A. nella cybersecurity: il primo riguarda la comprensibilità delle segnalazioni (explainability) cioè la presenza di un evento sospetto e non quale attacco è avvenuto, il secondo riguarda l’accuratezza delle segnalazioni cioè che ci siano falsi positivi o falsi negativi. Inoltre è necessario molto tempo nella conoscenza degli algoritmi; i suoi automatismi potrebbero generare disservizi in orari e giorni critici; ci vuole un addestramento continuo per rilevare nuove forme di attacchi informatici e quindi dei costi non indifferenti per l’azienda di manutenzione. Controlli di sicurezza in cloud, adozione di tecnologie IA/ML, nuova modalità di gestire il processo di produzione dei servizi digitali e nuovo modo di gestire gli allarmi sono le sfide da affrontare per chi si occupa di cybersecurity. Altre criticità sono rappresentate dal fatto che l’ I.A è dappertutto per i suoi vantaggi nell’automazione pertanto occorre scegliere gli ingredienti giusti per trarre i benefici e arrivare agli utenti con qualcosa che è umano e non lo è ...per aumentare l’efficacia crea verso gli utenti un impatto che deve essere gestito.

Bibliografia

CLUSIT - Intelligenza artificiale e sicurezza: opportunità, rischi e opportunità – marzo 2021

Rapporto CLUSIT 2021

Deepfake -Vademecum Garante per la protezione dei dati

Webinar: ICT Security Magazine -Cyber-security-virtual-conference-2021/27-maggio-2021 - Nuove prospettive tra Intelligenza Artificiale e Cyber Security-

Relatori: Prof. Francesco Santini, Professore Associato Università di Perugia Dipartimento di Matematica ed Informatica, Mariana Pereira, Director of Email Security, Darktrace, Mirco Destro Group CIO Beltrame Group, Carolina Polito, Research Assistant presso il Centre for Europeen Policy Studies (CEPS).

Sitografia

https://it.wikipedia.org/

https://www.garanteprivacy.it/

www.onoratoinformatica.it

www.intelligenzaartificiale.it

https://clusit.it/

https://www.zerounoweb.it/