ABSTRACT:

Quali effetti avrà l’evoluzione dell’automazione in futuro? Si creeranno nuovi posti di lavoro o verremo soppiantati dai robots? Quale impatto ha avuto l’interpretazione di Copenaghen dopo la conferenza di Solvay del 1927? Un oggetto macroscopico può effettivamente ritrovarsi in uno stato di correlazione quantistica? Dal principio di indeterminazione di Heisenberg secondo cui non è possibile determinare contemporaneamente la posizione e la velocità delle particelle subatomiche, ai fenomeni quali l’entanglement quantistico che porta a conseguenze logiche misteriose come il paradosso del gatto di Schrödinger, alla base della crittografia quantistica e del Quantum Computing.

L’EVOLUZIONE DELLE IA: DAI PRIMI ROBOTS ALLA MECCANICA QUANTISTICA

di Katia Canonico

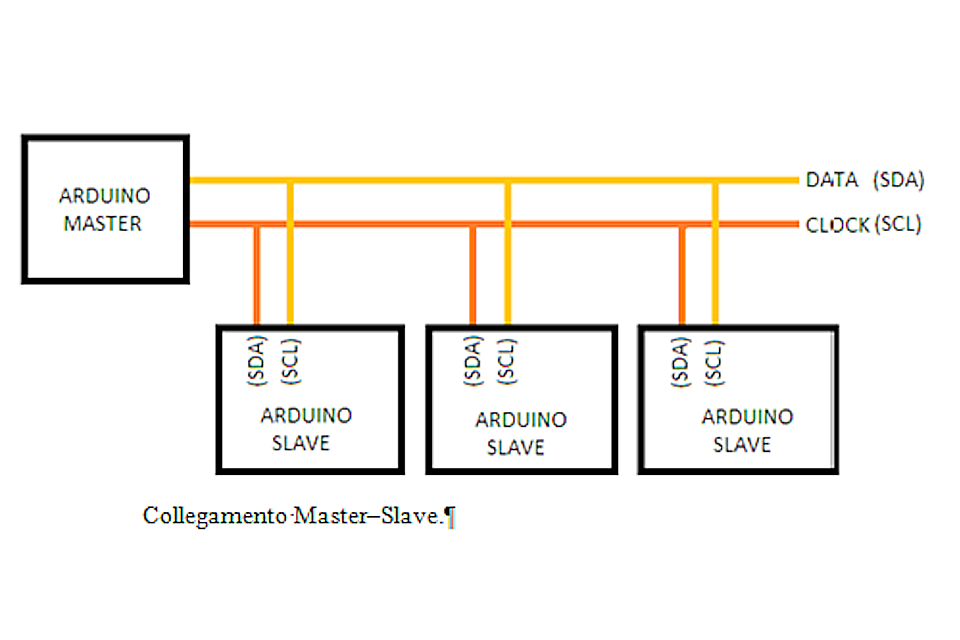

Nel 2017 ebbi l’occasione di partecipare alla Robocup JR rescue line. Allora il nostro team dell’Istituto Tecnico Industriale Statale “Enrico Fermi” di Castrovillari, utilizzò una scheda Arduino Mega 2560, che fa uso di un ATmega2560 ed è un’evoluzione dell’Arduino Mega, collegata alla scheda Arduino UNO + EV SHIELD tramite comunicazione I2C in cui ricopriva il ruolo di “Master”, mentre l’Arduino Uno + EV SHIELD quella di “Slave”. A tal proposito furono redatti due programmi software: uno per il Master e uno per lo Slave.

La comunicazione I2C è uno dei metodi che permettono di comunicare con altri dispositivi utilizzando come canale di trasmissione dati i protocolli seriali e ce ne servimmo in quanto l’uso della EV SHIELD sulla scheda Adafruit causava contrasti nei motori, dovuti all’identicità tra le variabili delle librerie.

La libreria Wire dispone di tutte le funzioni necessarie alla realizzazione Master-Slave tra due schede Arduino.

Il bus I2C, basandosi su due fili, non permette la comunicazione contemporanea tra Master e Slave. Lo scambio dati deve essere gestito dal Master tramite gli indirizzi (univoci) degli Slave. Il flusso può essere sintetizzato in questo modo:

- Il Master invia sul bus un bit di start

- Il Master invia sul bus l’indirizzo dello slave con cui vuole comunicare

- Il Master decide se scrivere o leggere dal dispositivo

- Lo Slave legge o scrive in base alla richiesta del Master

Ma come nasce la robotica?

Nel 1919, uno degli allievi di Freud, lo psicanalista Viktor Tausk, pubblicò un articolo intitolato “Sulla genesi della macchina influenzante nella schizofrenia”. In questo studio Tausk notava come fosse comune, a molti pazienti schizofrenici, la convinzione che esistesse una macchina elettrica capace di governare i destini degli uomini. Tausk arrivò ad elencare almeno due caratteristiche ricorrenti di questa macchina:

- la macchina invia sempre ai pazienti delle immagini con cui li influenza e li condiziona;

- la macchina produce e ruba i pensieri dei malati e con dei raggi elettrici li suggestiona.

Il termine robot vede la luce nel 1920, in un dramma distopico ceco “R.U.R.”, dove i lavoratori vengono sostituiti e sterminati da androidi efficienti. Nel 1939 Electro (figura a lato), uno scheletro di ingranaggi in ferro con un motore avvolto nell’alluminio, crea grande scalpore all’esposizione universale di New York: in questi anni la narrativa dipinge i robots come utili aiutanti o macchine malvagie che annientano i loro padroni.

In un film degli anni ’40, il robot maggiordomo Roll-Oh soddisfa tutte le esigenze di una casalinga.

Nel 1950 lo scrittore di fantascienza Isaac Asimov enuncia un codice morale dei robots:

- Un robot non può far del male ad un essere umano;

- Deve obbedire agli ordini ricevuti dal personale qualificato, a meno che non violino la regola numero uno;

- Un robot deve proteggere la propria esistenza, a patto di non violare la regola numero uno o due.

Nel 1961 la General Motors inserisce bracci robotici nella catena di montaggio per affrontare la crescente domanda di automobili in America. Nel 1966 la Nokia produce i primi bracci robotici per la Scandinavia e l’Europa dell’Est, nel 1969 la Kawasaki li fabbrica per il mercato asiatico, nel 1970 seguono BMW, Mercedes-Benz, British Leyland, Fiat che li impiegano nelle proprie fabbriche. Ma è il Giappone a sfruttare al massimo questa nuova tecnologia: nel 1981, infatti, nelle fabbriche di auto vengono impiegati 6000 robots a fronte dei 370 del Regno Unito (per questo, negli anni’80, l’industria automobilistica britannica è arretrata, incapace di competere con le auto più economiche importate dal Giappone). Oggigiorno, i tecnici giapponesi impiegano l’IA per generare robots più amichevoli e sensibili, come Asimo, sviluppato da Honda nel 2000. Il motivo è radicato nella religione: secondo gli antichi insegnamenti shintoisti, gli oggetti prodotti dall’uomo possono avere un’anima umana. Nel 2013, il robot umanoide di Toyota Kirobo, viene mandato sulla stazione spaziale internazionale per fare compagnia all’astronauta: i due trascorrono 18 mesi in orbita insieme. Sebbene i robots non provino sentimenti, essi vengono impiegati per sostegno emotivo; il Giappone è in testa, con 300.000 robots da compagnia: possono aiutare i bambini autistici a riconoscere e ad esprimere reazioni emotive, aiutano nell’assistenza agli anziani, insegnano e giocano con i bambini, rimpiazzano i genitori assenti e le mogli umane (dal 2016, più di 3700 uomini hanno scelto di sposare ologrammi robotici).

Nel 2020 condividiamo la Terra con 9 milioni di robots: circa 3 milioni lavorano in fabbrica, ma li troviamo anche sulle strade sotto forma di automobili a guida autonoma. Eppure il 72% degli americani teme che i robots porteranno via il lavoro agli umani. In una provincia cinese 2 milioni di lavoratori sono stati rimpiazzati dai robots in soli 2 anni. I robots sono presenti persino nei nostri ospedali: circa 5000 bracci chirurgici Da Vinci operano pazienti in tutto il mondo, nonostante il 69% degli americani si sente a disagio con i chirurghi robotizzati. Secondo Shoshana Zuboff, i nostri dati sono diventati il “nuovo petrolio”: l’intelligenza artificiale e la macchina algoritmica raccolgono i dati che ciascuno di noi lascia tramite i nostri comportamenti online.

La parola cognitive computing, cioè sistemi cognitivi capaci di lavorare deriva dall’IBM, che utilizzò questo termine, dal punto di vista commerciale, nel 2013 quando iniziò a pubblicizzare Watson, un insieme di servizi di intelligenza artificiale che già nel 2011 avevano battuto gli esseri umani in un gioco televisivo chiamato Jeopardy!. Nello stesso anno, nascevano i primi sintetizzatori vocali come Siri, che utilizzano tecnologie di reti neurali. Le reti neurali sono strutture simili a quelle del nostro cervello sebbene i “neuroni” delle reti neurali si dispongano in layers (o “livelli”). I neuroni del primo livello sono detti neuroni di input , mentre i neuroni dell’ultimo livello sono i neuroni di output; fra i neuroni di input e quelli di output sono presenti livelli cosiddetti “nascosti”: ogni neurone di ogni livello è collegato a tutti i neuroni del livello prima e a tutti i neuroni del livello dopo. Inoltre ogni collegamento ha a sua volta un numero, che viene chiamato peso, che rappresenta quanto forte o quanto debole sia la connessione fra quei due neuroni. Il primo modello di neurone artificiale venne progettato nel 1943 da Warren Sturgis McCulloch e Walter Pitts. Nel 2015, AlphaGo, progetto nato per studiare le reti neurali profonde, sconfisse il campione europeo di Go Fan Hui; nel 2016 si aggiudicò l’incontro contro uno tra i più forti giocatori mondiali di go, il sudcoreano Lee Sedol.

Ma cos’è l’intelligenza? E come è possibile determinare se una macchina è più o meno intelligente? Blaise Pascal (1623-1662) sosteneva che la nostra intelligenza è estremamente limitata. Il filosofo Douglas Hofstader in Gödel, Escher, Bach, scrive: ”Nessuno sa dove sia la linea di confine fra comportamento non intelligente e comportamento intelligente; di fatto, forse, non ha senso pensare che esista un confine netto. Ma certamente esistono delle caratteristiche essenziali dell’intelligenza: reagire in modo molto flessibile alle varie situazioni; trarre vantaggio da circostanze fortuite; capire messaggi contraddittori oppure ambigui; riconoscere l’importanza relativa di diversi elementi in una situazione; trovare i punti di somiglianza fra diverse situazioni, nonostante esse siano differenti; trovare i punti di differenza fra situazioni, nonostante esse siano simili; creare nuovi concetti prendendo vecchi concetti e mettendoli insieme in nuovi modi, inventare idee che siano nuove.” Già Ada Lovelace (1815-1852), figlia del poeta inglese Lord Byron, prefigurò il concetto di intelligenza artificiale, sebbene non ritenesse che la macchina potesse divenire pensante come gli esseri umani. Ada descrisse un algoritmo per la macchina analitica di Babbage (che si ispirò al telaio di Jacquard) per calcolare i numeri di Bernoulli: algoritmo che oggi viene generalmente riconosciuto come il primo programma informatico della storia.

Per determinare se una macchina sia in grado o meno di esibire un comportamento intelligente, si fa riferimento ad un criterio suggerito dal matematico inglese Alan Turing nel suo articolo Computer machinery and intelligence e noto come “test di Turing”. Per questo test, Turing prese spunto dal “gioco dell’imitazione” in cui sono presenti tre partecipanti: un uomo, una donna e una terza persona. Quest’ultima è separata dalle altre e deve stabilire, tramite una serie di domande, qual è l’uomo e quale la donna. A loro volta l’uomo ha il compito di ingannare e portare la terza persona a fare un’identificazione errata mentre la donna ha il compito di aiutarla. Se la percentuale di volte in cui la terza persona indovina chi sia l’uomo e chi sia la donna è simile prima e dopo la sostituzione dell’uomo con la macchina, allora la macchina dovrebbe essere considerata intelligente in quanto indistinguibile da un essere umano.

Per macchina intelligente Turing ne intendeva una in grado di concatenare ed esprimere pensieri non privi di significato. Nell’articolo, infatti, riprende il Cogito cartesiano secondo la quale l’uomo differisce dagli animali: gli animali sono res extensa, mentre l’uomo deve essere una res cogitans fatta di pensiero. Dagli anni ’70 fino agli anni ’90 infatti, l’intelligenza artificiale è stata basata sulla logica e cioè sulla capacità di emulare il nostro modo di ragionare (sia nella deduzione, che nell’induzione, che nella rappresentazione della conoscenza) a partire da John McCarthy, considerato il padre della logica computazionale, che inventò il linguaggio di programmazione Lisp che gli valse il premio Turing nel 1971. Sappiamo però che la nostra intelligenza non si limita soltanto alla logica ma, stando agli psicologi, possediamo tanti tipi di intelligenze (logico-matematica, tattile etc.); inoltre secondo il premio Nobel della medicina Eric Kandel la nostra intelligenza deriva certamente da una parte innata ma soprattutto dall’esperienza. Gli attuali algoritmi di intelligenza artificiale si sono evoluti sempre di più in quello che si chiama machine learning (o apprendimento automatico) e il deep learning (apprendimento profondo). Con machine learning si intendono quegli algoritmi che non sono stati codificati per un singolo problema ma che attraverso i dati ottimizzano i propri parametri (apprendono, appunto) e possono essere usati per diversi scopi. Per questi motivi, dal 2018 la Comunità europea ha dato un’altra definizione di intelligenza artificiale che non si limita soltanto all’emulazione prevista dal test di Turing ma che al contrario afferma che un’intelligenza artificiale deve occuparsi di sistemi che tendenzialmente fanno tre cose: hanno un comportamento intelligente, riescono ad estrarre informazioni dall’ambiente tramite sensori (capacità visiva, olfattiva, di riconoscimento del linguaggio, lavorano attraverso l’Internet of Things) e riescono ad intraprendere azioni (l’intelligenza artificiale è sicuramente software che è embodied in sistemi hardware che possono essere robots, auto, droni, aerei etc.). In questo momento le IA non possiedono un certo grado di autonomia per compiti specifici ma sono sottoposti a controllo da parte dell’essere umano: questo perché in Europa crediamo fortemente nell’Human-Centered AI, ovvero l’intelligenza artificiale centrata sull’uomo, in quanto l’IA non nasce semplicemente per rispondere alle interazioni con l’essere umano ma nasce soprattutto per essere trasparente, compresa e garantita dall’essere umano (si parla di intelligenza artificiale eXplainable). E cosa succederà quando l’intelligenza artificiale ci supererà in astuzia? Questo ipotetico punto di non ritorno è conosciuto come singolarità.

Nel maggio 1997, il computer di IBM Deep Blue, batté il campione mondiale di scacchi Garry Kasparov. Gli ingegneri dell’IBM programmarono Deep Blue affinché aspettasse alcuni minuti dopo aver concluso i calcoli, in modo tale da dare l’impressione che la macchina fosse incerta sul da farsi. Ciò fece abbassare la guardia a Kasparov, che dopo aver vinto la prima partita abbandonò la seconda, mentre la terza, la quarta e la quinta si conclusero con un pareggio: Deep Blue sconfisse Kasparov per 3 ½ contro 2 ½ . Il 4 Luglio 1997 il robot a guida autonoma si spinge lì dove nessun essere umano era mai arrivato: Marte. Grazie all’IA, Sojourner esplora per tre mesi il suolo di Marte, raccogliendo campioni e inviando 550 fotografie. Rover simili si rivelano indispensabili anche sulla Terra: sono utili a disinnescare ordigni nelle zone di guerra e salvare vite dal Kosovo all’Afghanistan mentre in Ruanda i droni trasportano sangue per trasfusioni in luoghi difficili da raggiungere. Da allora i computer divennero sempre più intelligenti grazie alla legge di Moore (secondo la quale il numero dei transistors raddoppia ogni 2 anni, aumentando in modo esponenziale la loro velocità e capacità) che permette di integrare un numero sempre più grande di transistors su unità di superficie.

Eppure esistono alcune cose che gli attuali computer non sono in grado di fare, come ricostruire alcune tipologie di molecole per studiarle nella loro completezza: esse, difatti, richiederebbero un numero inimmaginabile di bits (nel caso della molecola della penicillina il numero di bits ammonterebbe a 10^86…per rappresentarla occorrerebbe un computer grande quanto l’intero universo!). Ma cosa accade se arriviamo al limite in cui non si possono fare transistors più piccoli dell’atomo? Qui entra in gioco la meccanica quantistica la cui natura stessa è oggetto di dibattito tra gli scienziati, che si stanno ancora interrogando su di essa per assicurarsi che sia la teoria che funziona per qualsiasi sistema, indipendente dalle sue misure (la stessa giunzione p-n dei transistors segue le leggi della meccanica quantistica!). La fisica quantistica descrive il mondo microscopico attraverso l’equazione di Schrödinger, la cui soluzione talvolta non è una sola, bensì possono coesistere più soluzioni cioè più funzioni di stato o funzioni d’onda: la soluzione, per un sistema quantistico, è una sovrapposizione di stati, ovvero la somma di tutti gli stati in cui il sistema potrebbe trovarsi simultaneamente. La meccanica quantistica è importante per le scoperte tecnologiche in quanto permette di realizzare un computer quantistico potente che contenga un numero di unità quantistiche (Qubit): per fare ciò bisogna fare in modo che questo sistema resti in uno stato di sovrapposizione che necessita di essere isolato in quanto estremamente delicato, chiamato coerenza. A tal proposito ci serviamo di alcuni refrigeratori atti a portare la parte ad una temperatura più bassa della temperatura dello spazio interstellare (nello spazio interstellare è presente ancora un rimasuglio della temperatura dell’esplosione del Big Bang).

Uno dei paradossi quantistici è il paradosso del Sorite (dal greco antico σωρίτης sōritēs aggettivo di σωρός sōros, che significa "mucchio") paradosso da cui scaturisce per esempio la "teoria degli insiemi fuzzy" cioè una teoria di classi con contorni indistinti. Generalmente attribuito al filosofo greco Eubulide di Mileto, stabilisce che dato un mucchio di sabbia, se eliminiamo un granello dal mucchio avremo ancora un mucchio. Eliminiamo poi un altro granello: è ancora un mucchio. Eliminiamo ancora un granello e poi ancora uno: il mucchio diventerà sempre più piccolo, finché rimarrà un solo granello di sabbia. In quale momento quel mucchio iniziale non è più un mucchio? Un paradosso ben conosciuto dai fisici in quanto gli oggetti macroscopici seguono le leggi della fisica classica, mentre i quanti seguono la meccanica quantistica. Ma se tutto è formato da particelle e tutte le particelle seguono la meccanica quantistica, allora non dovrebbe tutto quanto seguire la meccanica quantistica? Quanto grande può essere il mucchio affinché abbia ancora comportamenti quantistici? Possibile far comportare un corpo visibile ad occhio nudo come un quanto? Per rispondere a queste domande, il team di Aaron Douglas O’Connell ha costruito un chip minuscolo e lo ha posto in uno stato particolare: una volta che il chip era stato schermato dalla luce, sistemato in un contenitore a cui era stata tolta l’aria e raffreddato ad una temperatura prossima allo zero assoluto, il chip ha cominciato a vibrare e a non vibrare allo stesso tempo, una cosa che può accadere solo nella meccanica quantistica.

Katia Canonico

Ex Studentessa ITIS "E.Fermi" Castrovillari

Studentessa di Ingegneria Elettronica presso UNICAL