Abstract: Le discipline umanistiche ,in particolare l’archeologia, sono sempre più orientate verso metodologie di analisi, studio e ricerca basate sull’utilizza dei big data, del machine learning e della robotica, riducendo tempi e costi, valorizzando e rendendo più accessibile il patrimonio culturale anche in chiave di sostenibilità e permettendo una conoscenza più approfondita delle diverse tematiche culturali.

*docente di Sistemi Automatici e Animatore Digitale presso l’ITIS “E.Fermi” di Castrovillari

L’Informatica umanistica, o Digital Humanities rappresenta quel campo di studi delle scienze umane che integra procedure computazionali e digitali con sapere umanistico, utilizzando la tecnologia e digitale non soltanto come strumenti operativi, ma come una nuova struttura del pensiero critico che superi la classica separazione fra i due saperi: umanistico e scientifico. Non si tratta di un semplice utilizzo del digitale per raccogliere e catalogare dati, bensì di rendere operativo in esso tutte le fasi della ricerca,dal reperimento delle fonti ,alla loro analisi e al loro inserimento critico nella rete del sapere. Eppure le Digital Humanities hanno un’origine abbastanza lontana risalente al 1946, quando padre Roberto Busa (Vicenza,1913, Gallarate,2011) ebbe l’idea di digitalizzare su supporto informatico, allora schede perforate, l’indice linguistico del corpus di Tommaso d’Aquino, un opera di proporzioni monumentali che fu realizzata in collaborazione con IBM. Da allora di strada ne è stata percorsa tanta e le Digital Humanities hanno abbracciato ogni campo del sapere umanistico, dalla linguistica alla filologia,dall’arte alla musicologia, dalla storia all’archeologia, cogliendo sfide ed opportunità sempre più nuove ed entusiasmanti dell’evoluzione del digitale e delle tecnologie come la robotica e l’intelligenza artificiale.

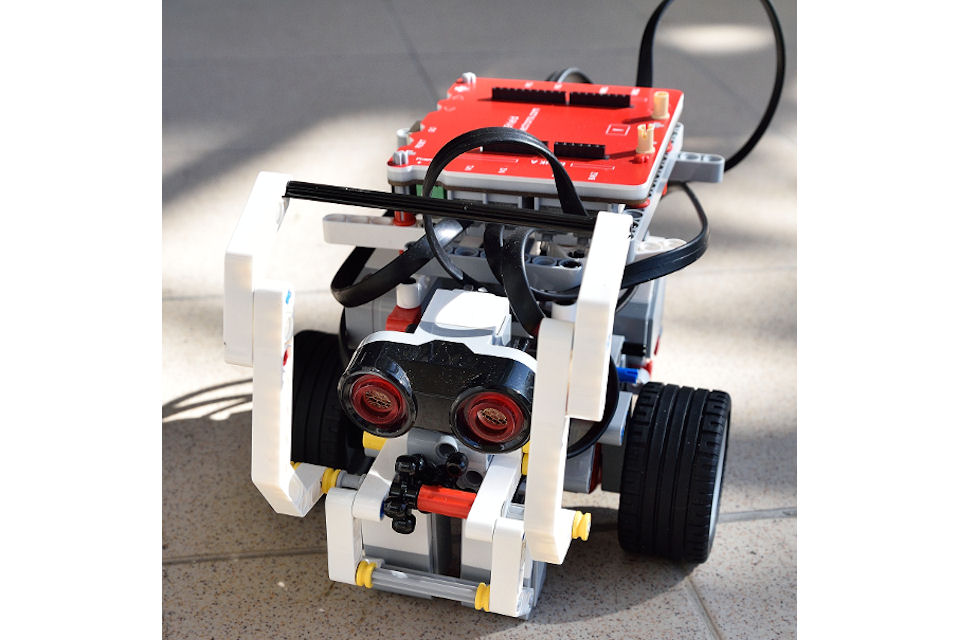

ROV (Remotely Operated Vehicle) è un robot per l’indagine e la conservazione subacquea di reperti , realizzato in collaborazione tra l’Istituto di Biorobotica della Scuola Superiore Sant’Anna di Pisa ed alcune aziende di ricerca sul campo( WASS,Ageotec, 3DResearch e Syremont). Il robot subacqueo è dotato di un braccio idraulico per la pulizia dei muri perimetrali sommersi che presenta su di un manipolatore diversi tipi di terminazioni:una spazzola,una pinza,una punta trapano. Il robot è,inoltre, dotato di una telecamera ottico-acustica per la ricostruzione 3D in tempo reale e di un’interfaccia grafica per gestire e monitorare da remoto le rotazioni e gli allungamenti delle sue giunzioni.

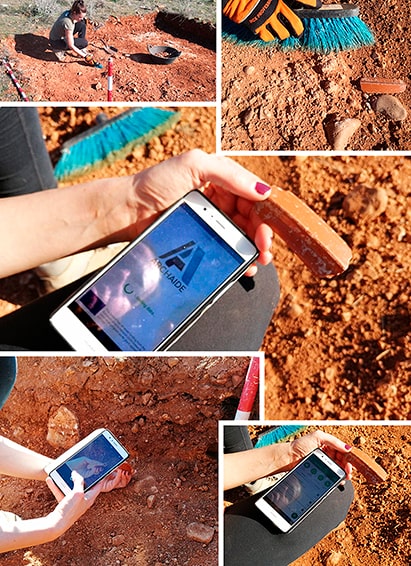

A Pompei, per la prima volta, sarà utilizzata una tecnologia all’avanguardia che consente di ricostruire gli affreschi del soffitto della Casa dei Pittori al Lavoro nell’Insula dei Casti Amanti ,con l’ausilio di bracci robotici che, mediante sofisticati sensori,sono in grado di scansionare i frammenti, riconoscerli tramite un sistema di digitalizzazione 3D e sistemarli nella loro giusta collocazione evitandone il minimo danneggiamento. Ciò si è reso possibile grazie al progetto europeo“RePAIR”(Reconstruction the past:Artificial Intelligence and Robotics meet Cultural Heritage), coordinato dall’Università ‘Ca Foscari che vede al lavoro la Ben Gurion University di Israele, l’Istituto Italiano di Tecnologia, l’università di Bonn in Germania e il Ministero della Cultura. Il progetto si pone l’obiettivo di risolvere il problema annoso della ricostruzione e il riconoscimento degli innumerevoli frammenti di anfore, affreschi, mosaici che giacciono per lungo tempo nei depositi archeologici ,che richiedono lunghissimi tempi di lavoro da parte degli archeologi e attendono di essere restituiti all’attenzione del pubblico in tutto il loro originario splendore. Un’utopia realizzata grazie al connubio tra archeologia e Intelligenza Artificiale è quella del progetto ArcAIDE ( Archeological Automatic Interpretation and Documentation of Ceramics), finanziato dall’Unione Europea e coordinato dalla professoressa Maria Letizia Gualandi del Dipartimento di Scienze dell’Antichità dell’Università di Pisa.  Il progetto consiste nella realizzazione di un sistema di riconoscimento automatico dei frammenti ceramici utilizzando l’Intelligenza Artificiale. E’ sufficiente scattare con un cellulare una foto del coccio da identificare e inviarla tramite un’app al sistema che, mediante una rete neurale addestrata , confronta forme e decorazioni con quelle archiviate nel suo data base interno e nel giro di pochi secondi formula cinque possibili interpretazioni identificative, fornendo per ciascuna di esse un valore numerico che rappresenta l’affidabilità della risposta. Spetta all’archeologo con la sua competenza decidere quale sia l’interpretazione migliore. Al contempo verranno memorizzate ed archiviate le nuove informazioni utili per le future ricerche. Tecnicamente vengono implementati due diversi algoritmi di riconoscimento: il primo dedicato al riconoscimento delle forme del frammento;il secondo al riconoscimento sulla base di generi. Si tratta esattamente dello stesso lavoro che fanno gli studenti di archeologia quando, per riconoscere e ricostruire la storia dei reperti, guardano e passano in rassegna migliaia di fotografie di frammenti alla ricerca delle corrispondenze con le immagini conservate nei cataloghi e negli archivi delle biblioteche e dei musei di tutto il mondo: una bibliografia estesa e non omogenea che difficilmente si può reperire quando si lavora sul campo o nei magazzini. L’Intelligenza Artificiale riduce di oltre l’80% il lavoro che gli archeologi solitamente spendono nella classificazione dei materiali di scavo. Ma perché tanti materiali di ceramica? E perché è importante studiarli e conservarli? L’argilla è una materia prima a basso costo e di facile lavorazione. Qualunque comunità,dal neolitico in poi, l’ha usata nella vita quotidiana per contenere e trasportare derrate alimentari. Si rompe, ma non si deteriora nel tempo. Una volta rotta non può più essere riutilizzabile, al contrario dei metalli che possono essere fusi e riutilizzati. Ecco perché le ceramiche sono una straordinaria finestra spalancata sulla vita quotidiana delle civiltà del passato con le loro informazioni preziose sulla datazione degli edifici, le sepolture, i flussi commerciali. Risparmiare tempo, oltre che denaro, per il riconoscimento e la datazione di tali reperti grazie all’aiuto dell’IA, è utile per la salvaguardia dell’immenso patrimonio archeologico dell’umanità. Ciò avviene anche quando gli archeologi sono chiamati a pronunciarsi in tempi rapidi durante i lavori per la costruzione di una metropolitana, di un a linea ferroviaria o di una qualsiasi opera pubblica o privata. Un analogo obiettivo persegue Il progetto Cultural Landascapes scanner coordinato dalla dottoressa Arianna Travaglia, direttrice del Centre for Cultural Heritage Tecnology dell’IIT con sede all’Università Ca’ Foscari di Venezia. Esso si pone ben oltre i tradizionali sistemi di telerilevamento LIDAR (Light Detection and Ranging) di cui gli archeologi si servono per rinvenire siti archeologici sepolti nel primo sottosuolo o nascosti da fitte foreste e vegetazioni. L’idea consiste nella progettazione di una piattaforma denominata Copernicus per la raccolta e l’archiviazione di immagini satellitari scattate dalle Sentinel-2 , i satelliti che coprono la superficie terrestre nel giro di 5 – 6 giorni. Utilizzando questa mole di immagini, il progetto ricerca potenziali siti archeologici utilizzando le tecniche di machine learning. E’ un’operazione di vero e proprio addestramento al riconoscimento della presenza di un sito archeologico proprio come gli archeologi sono in grado di fare con la loro esperienza. La macchina ,supportata dall’uomo,dovrà imparare gradualmente a svolgere questa attività. Una volta addestrata, la macchina –dice la dottoressa Travaglia- sarà in grado di vedere meglio degli archeologi, perché può manipolare immagini registrate nell’infrarosso che loro non possono vedere ad occhio nudo e anche perché elimina una buona parte della soggettività dell’essere umano. Con questa tecnica è possibile anche fare archeologia preventiva, ossia individuare siti archeologici prima che vengano coperti durante i lavori di costruzione di strade e parcheggi ( informazioni utili per chi si occupa di pianificazione territoriale) e di individuare i breve tempo siti clandestini. Sono queste soltanto alcune delle numerose esperienze che vanno efficacemente nella direzione del superamento della tradizionale contrapposizione tra cultura umanistica e cultura scientifica. L’archeologia è tra le discipline umanistiche che tra le prime ha adottato questo nuovo paradigma. Risale a cinquant’anni fa la più famosa conferenza di applicazione informatica all’archeologia. Da quel tempo è sempre più diventato importante per i giovani archeologi integrare la loro preparazione umanistica con competenze informatiche perché ,come dice la dottoressa Travaglia, laureata in storia a Venezia, specializzata in archeologia a Trieste con un dottorato in geomatica alla facoltà di ingegneria di Venezia , “è necessaria la presenza di una figura “ibrida”in grado di padroneggiare i due linguaggi : le scienze umanistiche e le scienze dure.” Nascere” archeologa è però fondamentale perché spesso l’errore è quello di volere applicare le discipline scientifiche alle scienze umanistiche senza comprenderne però le reali esigenze.”

Il progetto consiste nella realizzazione di un sistema di riconoscimento automatico dei frammenti ceramici utilizzando l’Intelligenza Artificiale. E’ sufficiente scattare con un cellulare una foto del coccio da identificare e inviarla tramite un’app al sistema che, mediante una rete neurale addestrata , confronta forme e decorazioni con quelle archiviate nel suo data base interno e nel giro di pochi secondi formula cinque possibili interpretazioni identificative, fornendo per ciascuna di esse un valore numerico che rappresenta l’affidabilità della risposta. Spetta all’archeologo con la sua competenza decidere quale sia l’interpretazione migliore. Al contempo verranno memorizzate ed archiviate le nuove informazioni utili per le future ricerche. Tecnicamente vengono implementati due diversi algoritmi di riconoscimento: il primo dedicato al riconoscimento delle forme del frammento;il secondo al riconoscimento sulla base di generi. Si tratta esattamente dello stesso lavoro che fanno gli studenti di archeologia quando, per riconoscere e ricostruire la storia dei reperti, guardano e passano in rassegna migliaia di fotografie di frammenti alla ricerca delle corrispondenze con le immagini conservate nei cataloghi e negli archivi delle biblioteche e dei musei di tutto il mondo: una bibliografia estesa e non omogenea che difficilmente si può reperire quando si lavora sul campo o nei magazzini. L’Intelligenza Artificiale riduce di oltre l’80% il lavoro che gli archeologi solitamente spendono nella classificazione dei materiali di scavo. Ma perché tanti materiali di ceramica? E perché è importante studiarli e conservarli? L’argilla è una materia prima a basso costo e di facile lavorazione. Qualunque comunità,dal neolitico in poi, l’ha usata nella vita quotidiana per contenere e trasportare derrate alimentari. Si rompe, ma non si deteriora nel tempo. Una volta rotta non può più essere riutilizzabile, al contrario dei metalli che possono essere fusi e riutilizzati. Ecco perché le ceramiche sono una straordinaria finestra spalancata sulla vita quotidiana delle civiltà del passato con le loro informazioni preziose sulla datazione degli edifici, le sepolture, i flussi commerciali. Risparmiare tempo, oltre che denaro, per il riconoscimento e la datazione di tali reperti grazie all’aiuto dell’IA, è utile per la salvaguardia dell’immenso patrimonio archeologico dell’umanità. Ciò avviene anche quando gli archeologi sono chiamati a pronunciarsi in tempi rapidi durante i lavori per la costruzione di una metropolitana, di un a linea ferroviaria o di una qualsiasi opera pubblica o privata. Un analogo obiettivo persegue Il progetto Cultural Landascapes scanner coordinato dalla dottoressa Arianna Travaglia, direttrice del Centre for Cultural Heritage Tecnology dell’IIT con sede all’Università Ca’ Foscari di Venezia. Esso si pone ben oltre i tradizionali sistemi di telerilevamento LIDAR (Light Detection and Ranging) di cui gli archeologi si servono per rinvenire siti archeologici sepolti nel primo sottosuolo o nascosti da fitte foreste e vegetazioni. L’idea consiste nella progettazione di una piattaforma denominata Copernicus per la raccolta e l’archiviazione di immagini satellitari scattate dalle Sentinel-2 , i satelliti che coprono la superficie terrestre nel giro di 5 – 6 giorni. Utilizzando questa mole di immagini, il progetto ricerca potenziali siti archeologici utilizzando le tecniche di machine learning. E’ un’operazione di vero e proprio addestramento al riconoscimento della presenza di un sito archeologico proprio come gli archeologi sono in grado di fare con la loro esperienza. La macchina ,supportata dall’uomo,dovrà imparare gradualmente a svolgere questa attività. Una volta addestrata, la macchina –dice la dottoressa Travaglia- sarà in grado di vedere meglio degli archeologi, perché può manipolare immagini registrate nell’infrarosso che loro non possono vedere ad occhio nudo e anche perché elimina una buona parte della soggettività dell’essere umano. Con questa tecnica è possibile anche fare archeologia preventiva, ossia individuare siti archeologici prima che vengano coperti durante i lavori di costruzione di strade e parcheggi ( informazioni utili per chi si occupa di pianificazione territoriale) e di individuare i breve tempo siti clandestini. Sono queste soltanto alcune delle numerose esperienze che vanno efficacemente nella direzione del superamento della tradizionale contrapposizione tra cultura umanistica e cultura scientifica. L’archeologia è tra le discipline umanistiche che tra le prime ha adottato questo nuovo paradigma. Risale a cinquant’anni fa la più famosa conferenza di applicazione informatica all’archeologia. Da quel tempo è sempre più diventato importante per i giovani archeologi integrare la loro preparazione umanistica con competenze informatiche perché ,come dice la dottoressa Travaglia, laureata in storia a Venezia, specializzata in archeologia a Trieste con un dottorato in geomatica alla facoltà di ingegneria di Venezia , “è necessaria la presenza di una figura “ibrida”in grado di padroneggiare i due linguaggi : le scienze umanistiche e le scienze dure.” Nascere” archeologa è però fondamentale perché spesso l’errore è quello di volere applicare le discipline scientifiche alle scienze umanistiche senza comprenderne però le reali esigenze.”

“Se dai un pesce ad un affamato lo sfami per un giorno, se gli insegni a pescare lo sfami per tutta la vita”

“Se dai un pesce ad un affamato lo sfami per un giorno, se gli insegni a pescare lo sfami per tutta la vita”